miércoles, junio 29

Manual de seguridad para Facebook

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

6/29/2011 05:48:00 p. m.

jueves, abril 21

201X El año del Data Center

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

4/21/2011 12:47:00 p. m.

jueves, octubre 7

Navegadores web procesando Datos. La llegada de Terminator?

La inquietud principal que motivo este post es sencilla.. Estamos en el preámbulo de que los Browsers actuales se conviertan en los próximos grandes procesadores de información? Identificada la inquietud como sencilla, ahora veamos qué tan complicada es su respuesta..

Procesamiento Distribuido

Una de las primeras cosas que se encuentran en una busqueda sencilla sobre este tema son estándares que en su descripción te ponen a pensar en la posibilidad de una súper computadora ejecutándose en internet con procesamiento casi imposible de dimensionar tomando recursos de cada computadora conectada a la red y a su red, algo parecido a la computadora Skynet que nos presentan en la saga Terminator, pero sin los modelos que rezan “hasta la vista babe”.

La realidad sería algo mucho más sobrio para bien de la humanidad, por lo pronto estándares como el RPC (Remote Procedure call) se presenta como un método de procesamiento distribuido que permite invocar funciones y procedimientos escritos cada uno pudiendo estar en lenguajes de programación diferentes, que serían ejecutados de manera remota desde una maquina diferente como un solo proceso, bajo la modalidad de presentación XML, es decir WEB.

Imagínense pues una aplicación con funciones creadas en distintos lugares, en distintos lenguajes de programación, siendo ejecutadas de manera remota, con una sola, en cualquier plataforma y soporte tipo SOAP…

Es más o menos lo que conocemos hoy en dia no? Pero lo hacemos totalmente WEB? Que tienen los navegadores actuales para realizar esto?

Fuera INTEL-AMD, entra JavaScript??

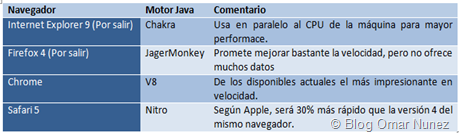

En las presentaciones de cada uno de los principales navegadores a la comunidad de programadores, por parte de las empresas que los crean, siempre el foco principal lo obtiene el motor JavaScript, según muchos foros hay acuerdo en que los presentan con gráficos y estadísticas dignas de una presentación para productos de INTEL o AMD. A continuación una recopilación principales navegadores y sus ultimos motores presentados:

Evolución de los navegadores

Hoy en día los Navegadores están integrados como pocas aplicaciones a la red y lo hacen ejecutando aplicaciones de manera estandarizada sin importar el sistema operativo. Solo con las diferencias de velocidad proporcionadas por sus respectivos motores de Java.

Visión Google

Google por el empuje que dio con sus conceptos presentados y materializados en el reléase de Chrome tiene una parte protagonista en esta tendencia. Entre las cosas originales y destacadas que presento Google están:

“Una pestaña, un Proceso

Cada pestaña se ejecuta sobre un proceso por lo que la caída de una de ellas no será motivo para cortar el proceso del navegador y reiniciarlo. Además gráficamente podemos movilizar una pestaña transportándola a otra instancia del navegador Chrome y ubicando su proceso en otro conjunto de procesos. O dejarla en el aire creando su propio grupo de procesos.

Administrador de Tareas:

Como consecuencia de la presencia de procesos Google Chrome provee de un Task Manager que permite monitorear los niveles de descarga, medidas de consumo de CPU y Memoria RAM. Este administrador también nos permite cortar un proceso. Nuestra principal motivación para emplear este aniquilador de procesos será un sitio web del que no obtenemos respuesta o que sobrecarga al sistema.”

Adicional a esto todos conocemos el paso presentado por Google de su navegador corriendo en una maquina sin sistema operativo pudiendo hoy en dia hacer casi todas las operaciones, siendo esta una modalidad de mucho potencial para temas como:

- · Cloud Computing

- · Terminales “brutas”de trabajo (ThinClient)

- · Virtualización

- · SOA

- · Entre otros.

Donde estamos ahora

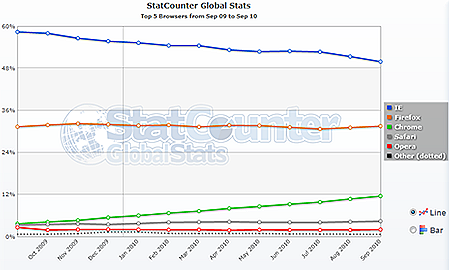

Recientemente tenemos un movimiento de las cuotas de mercados, próximos releases, y tendencias sobre nuevas funciones - avances.

Market Share actual de Web Browsers

Conclusión

Los navegadores con su motor propio de JavaScript pretenden funcionar con un principio similar al de máquinas virtuales, permitiéndoles hacer las veces de CPU y llevar las posibilidades a un próximo nivel, ya IE9 promete aceleración grafica integrándose muy de lleno con la tarjeta de video del equipo, lo que lleva la definición visual a otro nivel. La evolución de estos, indiscutiblemente nos llevaría a una convergencia de computación entre dispositivos de distintas plataformas, llevar la colaboración masiva, llevarla a otro nivel.

“Hasta la Vista…

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

10/07/2010 03:34:00 p. m.

viernes, septiembre 3

Ser Tech Cool cuesta mucho…

En estos días de ferias sobre equipos móviles, conferencias de empresas y workshops tenemos un verdadero bombardeo de lanzamientos, lógicos de la época en donde las empresas de consumo masivo intentan posicionarse en miras al último tercio del año, temporada de compras marcada por el Black Friday y terminando con el fin de año. Celulares, consolas de entretenimiento, tv por internet, notebooks, tv inteligentes serán impuestos como temas obligatorios a medida que pase el tiempo.

En estos días de ferias sobre equipos móviles, conferencias de empresas y workshops tenemos un verdadero bombardeo de lanzamientos, lógicos de la época en donde las empresas de consumo masivo intentan posicionarse en miras al último tercio del año, temporada de compras marcada por el Black Friday y terminando con el fin de año. Celulares, consolas de entretenimiento, tv por internet, notebooks, tv inteligentes serán impuestos como temas obligatorios a medida que pase el tiempo.

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

9/03/2010 04:16:00 p. m.

miércoles, julio 28

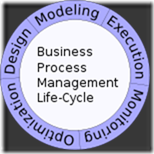

Business Processes

Definición, aporte actual, estructura

Business Processes Management (BPM) o Gestión de Procesos es un conjunto de acciones integrales, de flujos, procedimientos y procesos de gestión analítica, apoyada por la tecnología, que aborda todas las actividades de su empresa; es un enfoque de gestión centrado en la adaptación de todos los aspectos de una organización con los deseos y necesidades de los clientes. Al tratarse de un enfoque de gestión integral que promueve la eficacia y eficiencia empresarial actuando en favor de la innovación, podría ser descrito como un proceso de optimización.

Estructura tradicional

Se argumenta que BPM permite a las organizaciones ser más eficiente, más eficaz y más capaz de cambiar de un funcional centrado que es el enfoque tradicional de gestión jerárquica y obsoleto que plantea los departamentos de una organización como silos en su comunicación, desarrollo, operación y medición.

El enfoque orientado a procesos crea un corte transversal a esta estructura de sios viendo, midiendo y comunicando a la empresa por procesos, involucrando en estos, elementos multidisciplinarios de toda la organización.

Ejemplo:

Desde el punto de vista de un cliente, el mismo puede realizar una solicitud de préstamo para vehículos en un banco. Los procedimientos y manejos que procesan esta solicitud abarcan varios departamentos que en la estructura jerárquica tradicional son medidos por separado, y los problemas o choques que puedan existir en la definición de eficiencia que pueda tener cada uno hacen que procesos invisibles al cliente le afecten la calidad y garantía del servicio solicitado. Por ejemplo un departamento que se mida por volumen de solicitudes y alimente a otro que se mida por tiempo de trámite en cada solicitud.

Estructura BPM

BPM + IT

Se podría decir que el mercado de BPM de lleno en el campo IT nace en el 2005 con la salida al mercado de los BPMS (Business Processes Management Systems) aunque solo tiene 5 años ya Gartner publico un estudio donde lo colocaba como una de las áreas de IT con mayor crecimiento entre 2007 y 2011 pasando de un mercado de 1Billon anual a 2.6 en ese periodo de tiempo.

http://www.gartner.com/it/page.jsp?id=502645

Un BPMS permite no solo diseñar la estructura de un proceso, al modelarse bajo sistema este crea el proceso en sí, al crear un flujograma que describa las actividades y su secuencia al mismo tiempo se crea el formulario electrónico, el repositorio y los controles que necesitara el sistema web-based para su funcionamiento. Simulación de procesos y arquitectura SOA son entregables de un sistema BPMS.

Esquema de una suite BPM completa

Esto aporta en 4 aspectos básicos:

- · Estrategias

- · Governance (Administración y Control)

- · Estructura Organizacional (Organization)

- · Cultura organizacional

Otros beneficios identificados:

- Adquirir la habilidad para diseñar, simular y monitorear procesos de manera automática y sin la participación de usuarios técnicos.

- Posibilidad de integrar la información dispersa del negocio en diferentes sistemas.

- Visibilidad de los procesos de la empresa.

- Mayor flexibilidad y agilidad para adaptación al cambio.

- Reducir costos futuros de integración y mantenimiento al adquirir tecnología ya preparada para abordar el cambio.

- Mejorar el conocimiento de las funciones y atribuciones de cada puesto de trabajo.

Fuente Value add

Importancia

- · Necesidad de procesos repetitivos y predecibles

- · Consolidación de los datos

- · Necesidad de indicadores no financieros

- · Alineación de los empleados con los objetivos corporativos

Principales Suites o Frameworks

- · IBM Lombardi

- · Oracle SOA Suite

- · IBM BPM

- · BEA AquaLogic BPMS

- · BizAgi

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

7/28/2010 03:10:00 p. m.

domingo, marzo 14

La desduplicación – Tendencia en Backup

Tags:

- Desduplicacion

- Niveles

- Tipos de políticas

- Que hay que tomar en cuenta para implementar una solución de Backup hoy en día.

Hace unos años la duplicación, clonación, redundancia, centralización, fueron conceptos y palabras que repetidamente surgían en los papeles blancos, revistas, reportes y publicaciones propias al manejo de las plataformas tecnológicas, data centers, y IT Operations; desde hace un tiempo prudente a la fecha, viene surgiendo el concepto desduplicacion, de una manera directamente proporcional al avance que se ha tenido en los primeros conceptos referidos por lo que no es un concepto nuevo, pero sí de uso limitado.

La desduplicacion permite la eliminación de datos redundantes al sistema de Backup, lo que reduce costes de adquisición, almacenamiento, tiempo, y manejo. Actualmente todas las tecnologías, con uno u otro nombre se dividen en:

Desduplicación a nivel de bloque

Desduplicación a nivel de archivo

Con cualquiera de los dos niveles se puede llegar a un nivel de eficiencia entre 50y 90% adicional al sistema tradicional, por ejemplo uno de sus usuarios envía un reporte de Excel, cargado de gráficos, imágenes y ratios de resultados de mes, al poseer fotos el archivo de 7 megas es enviado a 11 personas de nivel directivo. Al momento de su sistema de Backup respaldar este solo mail se convertirá en 84 megas sin contar con ni un solo foward o replay with attachment que se realice. Multiplique esta actividad por instancias de datos duplicados por toda la organización y entenderá porque el crecimiento exponencial de la data, así como el porqué la desduplicacion ahorra tanto.

Aunque la desduplicación puede ahorrar enormes cantidades de espacio de disco, su concentración hace que un almacenamiento correcto tenga una importancia crítica. Si un bloque de datos encontrado en varios orígenes (como en el ejemplo anterior del archivo excel) se desduplica y luego se pierde, todas las copias de seguridad asociadas al mismo quedarán dañadas, ya que los datos de origen ya no existen. También se aplica a copias de seguridad completas de sistemas. Si se produce una catástrofe, un solo bloque de datos dañado correspondiente a una parte vital del sistema operativo Windows hará que todas las copias de seguridad queden inutilizables en caso de recuperación del sistema. Estudie el uso de una matriz RAID para almacenar datos de desduplicación para proporcionar un nivel de protección adicional.

Estilos política de Desduplicacion

Desduplicación en destino

La desduplicación en destino tiene lugar después de realizar la copia de seguridad del origen, cuando ya los datos están en la ubicación de almacenamiento de destino, normalmente un nodo de almacenamiento conectado (NAS). Su desventaja es el uso de un posible ancho de banda limitado especialmente para casos de backup en instalaciones remotas.

Desduplicación en origen

La desduplicación en origen (o del servidor) es la que se realiza en el servidor que contiene los datos y luego son enviados vía análisis de algoritmo de paquetes al servidor de almacenamiento. Su desventaja es el uso de ciclos de CPU en el servidor origen.

La elección entre la desduplicación en origen o en destino dependerá de cuál es la limitación (consumo general de proceso de CPU de cliente o consideraciones de ancho de banda) más importante para su organización. Una mala elección podría ocasionar en la eliminación total de un proyecto de desduplicacion por colapsos en la red, o respuesta nula de un servidor por sobre procesamiento.

Que hay que tener en cuenta para implementar una solución de Backup basada en Desduplicación

Hay muchas soluciones, con muchas nuevas alternativas para el respaldo de la información, un sistema a la vanguardia en equipos de alto desempeño entiendo que definitivamente tiene que contar con desduplicacion desde las estaciones de trabajo, maquinas virtuales y servidores. Permitiendo el manejo de imágenes a estos últimos actualizables, para permitir tener una imagen de archivos y sistema operativo de nuestros servidores actualizada de manera automática y remota. Las opciones son varias, pero partiendo de un equipo de alto desempeño se podría desglosar en orden descendente a partir de los siguientes tópicos.

La solución a implementar debería de cumplir con los siguientes requisitos:

- - Permitir los dos niveles de Desduplicacion, a nivel de archivo y nivel de bloque.

- - Permitir una desduplicacion tanto en origen como en destino.

- - Poseer un algoritmo inteligente en despublicacion origen que consuma menos CPU que los primeros algoritmos de la desduplicacion de años atrás.

- - Tener versiones Linux, Windows para servidores así como poder integras VIP Workstation.

- - Tener capacidad de trabajar con maquinas virtuales.

- - Copias de imágenes incrementales y automatizadas.

- - Modulo Disaster recovery.

- - Integración a sistema NAS.

Imagenes Acronis Website

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

3/14/2010 04:21:00 p. m.

sábado, febrero 20

Procesadores Cuánticos – De Relatividad de Einstein a Ley de Moore

Para ayudar recientemente en una tarea universitaria me toco explicarle a alguien el concepto de procesadores cuánticos de manera muy básica, por eso aunque es algo que ya muchos conocemos y hemos leído, se me ocurrió que era buena excusa para, para ver los últimos avances sobre el tema así como su posible implementación definitiva.

Para eso como es de costumbre primero hagamos un repaso sobre lo que es el concepto; iniciando con que los procesadores, ese elemento electrónico que se encarga de interpretar - procesar los datos de los programas con el hardware y que es el negocio fundamental de Intel y AMD, es la parte quizás más importante de una computadora. Es un sistema de circuitos integrados los cuales sustituyeron en el siglo XX a los tubos de vacío y válvulas de las primeras computadoras, hoy en día son el corazón de un teléfono celular o un horno microondas. Su velocidad viene dada por el numero de transistores (generalmente de silicio) que se podían colocar por pulgada, y el trabajo se resumió a hacer de estos cada vez más pequeños para elevar el número de MHz de los procesadores.

Ley de Moore

La Ley de Moore expresa que aproximadamente cada 18 meses se duplica el número de transistores en un circuito integrado.1 Se trata de una ley empírica, formulada por el co-fundador de Intel, Gordon E. Moore el 19 de abril de 1965, cuyo cumplimiento se ha podido constatar hasta hoy. Más tarde, en 1975, modificó su propia ley al afirmar que el ritmo bajaría, y que la capacidad de integración se duplicaría aproximadamente cada 24 meses. Sin embargo, el propio Moore ha puesto fecha de caducidad a su ley: "Mi ley dejará de cumplirse dentro de 10 o 15 años -desde 2007-".6 Según aseguró durante la conferencia en la que hizo su predicción afirmó, no obstante, que una nueva tecnología vendrá a suplir a la actual.

Teoría de la relatividad de Einstein

El inicio de los procesadores va en orden cronológico con el inicio de la mecanica cuántica producto del aporte de muchísima gente y donde resaltamos el aporte de la teoría de la relatividad en 1905 (en donde está la famosa e=mc^2) de Albert Einstein que entre otras cosas trabajo en lo que seria el inicio de la mecanica cuántica.

Procesadores Cuánticos

La idea surge en 1981, cuando Paul Benioff expuso su teoría para aprovechar las leyes cuánticas en el entorno de la computación. En vez de trabajar a nivel de voltajes eléctricos, se trabaja a nivel cuántico. En la computación digital, un bit sólo puede tomar dos valores: 0 ó 1. En cambio, en la computación cuántica, intervienen las leyes de la mecánica cuántica, y la partícula puede estar en superposición coherente: puede ser 0, 1 y puede ser 0 y 1 a la vez (dos estados ortogonales de una partícula subatómica). Eso permite que se puedan realizar varias operaciones a la vez, según el número de qubits.

El número de qubits indica la cantidad de bits que pueden estar en superposición. Con los bits convencionales, si teníamos un registro de tres bits, había ocho valores posibles y el registro sólo podía tomar uno de esos valores. En cambio, si tenemos un vector de tres qubits, la partícula puede tomar ocho valores distintos a la vez gracias a la superposición cuántica. Así un vector de tres qubits permitiría un total de ocho operaciones paralelas. Como cabe esperar, el número de operaciones es exponencial con respecto al número de qubits. Para hacerse una idea del gran avance, un computador cuántico de 30 qubits equivaldría a un procesador convencional de 10 teraflops (millones de millones de operaciones en coma flotante por segundo) cuando actualmente las computadoras trabajan en el orden de gigaflops (miles de millones de operaciones).

Implicaciones

La consecuencia directa de la Ley de Moore es que los precios bajan al mismo tiempo que las prestaciones suben: la computadora que hoy vale 3000 dólares costará la mitad al año siguiente y estará obsoleta en dos años. En 26 años el número de transistores en un chip se ha incrementado 3200 veces.

Al tomar como referencia para una nueva ley sobre el avance de procesamiento que sustituya la ley de Moore dentro de los procesadores; adaptándola con el salto exponencial de los procesadores cuánticos, los costos, las prestaciones y los tamaños que tendrán permitiendo un mayor campo de aplicación quizás nano-procesadores aplicables a dispositivos y computadoras microscópicas. Las implicaciones de este campo podrían representar todo un nuevo salto tecnológico de repercusiones incalculables.

Ultimas Actualizaciones (Fuente Externa)

Para actualizarnos sobre el tema les comparto un resumen encontrado en internet donde se puede apreciar los últimos avances en una vista de tipo cronológico que nos permite saber actualmente como se desarrolla el avance de los procesadores cuánticos y los distintos tipos de modelos que se disputan el estándar producto del correcto manejo de la probabilidad de posición de los electrones y el cálculo en tiempo del estas 0 y 1 de los qubits.

2000 - Continúan los progresos

De nuevo IBM, dirigido por Isaac Chuang (Figura 4.1), creó un computador cuántico de 5-Qbit capaz de ejecutar un algoritmo de búsqueda de orden, que forma parte del Algoritmo de Shor. Este algoritmo se ejecutaba en un simple paso cuando en un computador tradicional requeriría de numerosas iteraciones. Ese mismo año, científicos de Los Álamos National Laboratory (EE.UU) anunciaron el desarrollo de un computador cuántico de 7-Qbit. Utilizando un resonador magnético nuclear se consiguen aplicar pulsos electromagnéticos y permite emular la codificación en bits de los computadores tradicionales.

2001 - El algoritmo de Shor ejecutado

2005 - El primer Qbyte

El Instituto de “Quantum Optics and Quantum Information” en la universidad de Innsbruck (Austria) anunció que sus científicos habían creado el primer Qbyte, una serie de 8 Qbits utilizando trampas de iones.

2006 - Mejoras en el control del cuanto

Científicos en Waterloo y Massachusetts diseñan métodos para mejorar el control del cuanto y consiguen desarrollar un sistema de 12-Qbits. El control del cuanto se hace cada vez más complejo a medida que aumenta el número de Qbits empleados por los computadores.

2007 - D-Wave

La compañía canadiense D-Wave presenta públicamente su primer computador cuántico de 16 Qbit. Entre las aplicaciones que presenta para su sistema, se encuentra un sistema gestor de bases de datos y un algoritmo que soluciona Sudokus. Todo ello a través de una interfaz gráfica similar a la utilizada en los computadores actuales, tratándose del primer acercamiento de la computación cuántica al mundo comercial y no tan científico.

2007 - Bus cuántico

En septiembre de 2007, dos equipos de investigación estadounidenses, el National Institute of Standards (NIST) de Boulder y la Universidad de Yale en New Haven consiguieron unir componentes cuánticos a través de superconductores. De este modo aparece el primer bus cuántico, y este dispositivo además puede ser utilizado como memoria cuántica, reteniendo la información cuántica durante un corto espacio de tiempo antes de ser transferido al siguiente dispositivo.

2008 - Almacenamiento

Según la Fundación Nacional de Ciencias (NSF) de los EEUU, un equipo de científicos consiguió almacenar por primera vez un Qubit (el equivalente a un "bit" del "mundo clásico", pero en el "mundo cuántico") en el interior del núcleo de un átomo de fósforo, y pudieron hacer que la información permaneciera intacta durante 1.75 segundos. Este periodo puede ser expansible mediante métodos de corrección de errores, por lo que es un gran avance en el almacenamiento de información.

2009 - Procesador cuántico de estado sólido

Comparte este Post:

Check out this article:

Publicado por

Omar Nuñez

en

2/20/2010 04:57:00 p. m.